嗨嗨,大家好,我是精靈。

身為畢業兩年左右的菜鳥,因為意外不小心跳入了infra火坑,爬上來之後又意外吃了LLM這塊餅。接觸了一些研究單位、新創、傳產,意外發現大家都對infra沒有什麼認識,甚至很多人都不知道什麼是infra工程師。

不過大家都想一起快樂的畫大餅,抱有一個想要做一個local LLM服務的夢想。雖然了解不深,只知道可以call OpenAI的API、好像有GPU顯卡就可以下載模型跑了,中間怎麼做怎麼設定就不知道了。

這邊遇過到一個情境是:

有公司不信任大公司的API或資料儲存服務,怕文件機密外流。沒太多預算買設備卻想要local服務,想自己架設,不想要準確度差,又想要速度快,多人使用都沒問題。

這也是寫這個主題的原因,讓我們一起來研究這個local LLM服務的夢想!

在這個狀況下,基礎建設是最重要的,好的基礎建設才能讓後面那些工程師和user快樂的玩AI。

(圖源: 網路)

目前規劃的30天主題如下,推理相關技術的分類參考了幾篇論文。

本系列文章將針對小公司經費、設備不足去探討該怎麼做可以節省成本;也針對大公司的infra架構去介紹資料中心的設計,有什麼方法最佳化運用所有的GPU計算資源。

另外如果還有餘力,想寫一些大學/研究所時基本上沒學過,但是工作就突然要會的一些東西。

雖然目前有很多優化地端模型、加速的方法,但每個方法都會各有優缺,就看使用上要怎麼做平衡了。本文完全不考慮model training或fine-tuning的部分,全部以LLM相關infra知識和各種LLM推理(inference)加速方法為主。

因自身還很資淺,若有哪裡寫得不對,歡迎資深工程師大大們提出,謝謝!

(圖源: 網路)

梗圖解釋:IT infrastructure就像是一座城市的基礎建設,上面跑的車則是程式碼,開車的是工程師。假設不重視infra的話,每建設一條新的高速公路,就隨便往上蓋,最後變得跟迷宮一樣,人開車容易迷路,還會花更久的時間抵達目的地。

假設一般CPU系統的狀況下,蓋的是高速公路,但為了local LLM,GPU要蓋的可能是高速鐵路,那又需要更多的設備經費和專業,出現的問題可能也更多。

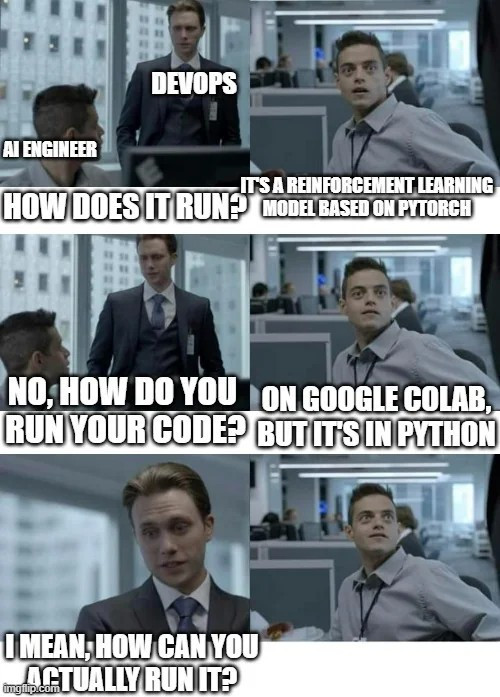

[雖然學校會教在別人建的環境中跑程式,但沒有教要怎麼做基礎建設和後續的維運]

(圖源: reddit,這張同樣放在Day28中)

參考推理相關技術的論文做分類

A Survey on Efficient Inference for Large Language Models

https://arxiv.org/pdf/2404.14294

LLM Inference Unveiled: Survey and Roofline Model Insights

https://arxiv.org/pdf/2402.16363